ポケモンの画像認識で遊んでみた

先月ランクマのスクリーンショットがいっぱい手に入ったので画像認識で遊んでみました。

遊び道具

・ポケモン剣盾

→ランクマのスクリーンショットをたくさん撮りました。

→Googleが提供している機械学習を行えるサービス。

なんとノーコードで機械学習ができちゃいます。

機械学習してみる

ランクマで取ったスクリーンショットから相手が今何のポケモンを場に出しているのか?を推定したいと思います。

使用するデータ

↓こんな感じの相手と対面している画像を何枚か用意しました。

学習する

なんとなく対面画像が多そうなポケモンとして「ザシアン」「バドレックス」「カイオーガ」「ネクロズマ(日食)」、この4体を選びました。

それぞれの対面画像を「画像サンプル」として「Teachable Machine」読み込ませました。

適当にフォルダを漁って収集したので、サンプル数は適当です。

読み込ませるとこんな感じ↓

学習の結果

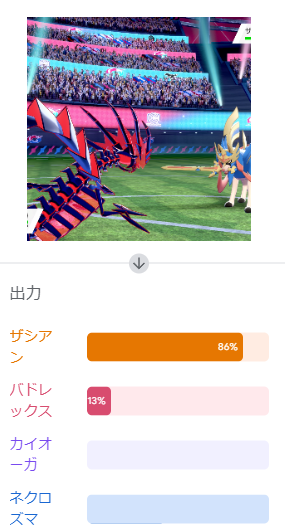

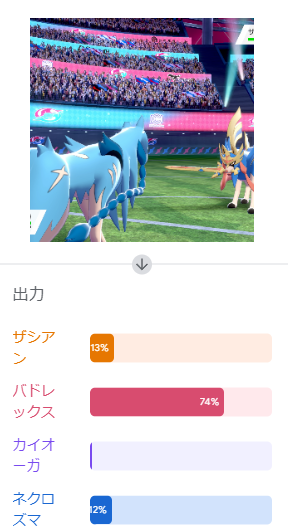

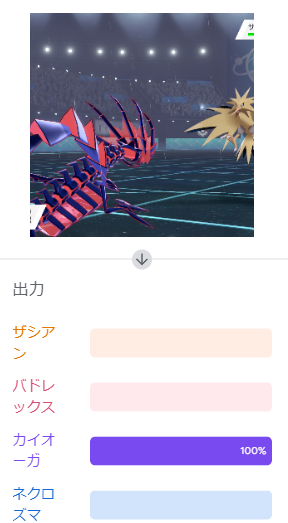

学習したモデルを使って画像を判定してみます。

学習時と同じように画像を読み込ませると・・・

イケてるやん!!

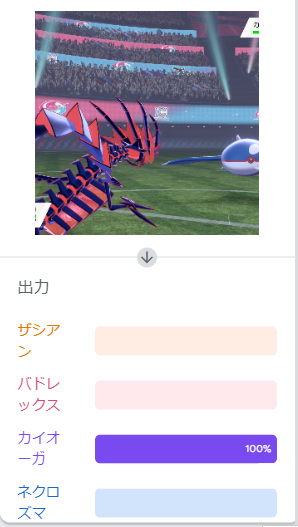

他のポケモンも試してみます。

いい感じに認識できていますね。

サンプル数少ないですし、右半分だけになるようにトリミングして認識させないと不要な情報が多いかなと懸念していましたが、大丈夫そうですね。

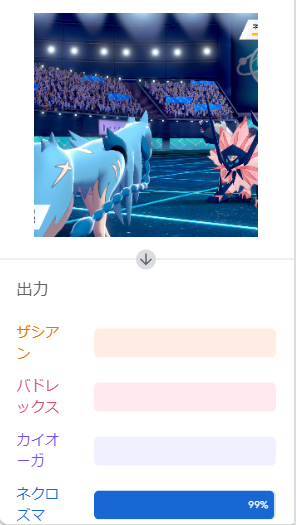

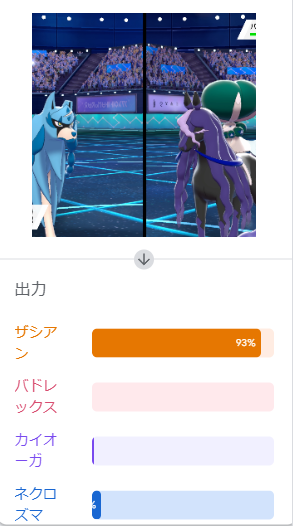

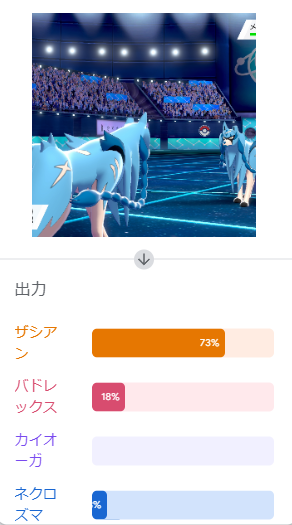

もう少し試してみましょう。

ん?

バドレックス?いかつい黒馬ですね。黒くもないし。

あっ!たまたまうまくいっただけみたいでした。

結構誤検出しますね。

学習結果で遊んでみる

とりあえず学習できたので(誤検出は置いといて)色々遊んでみましょう。

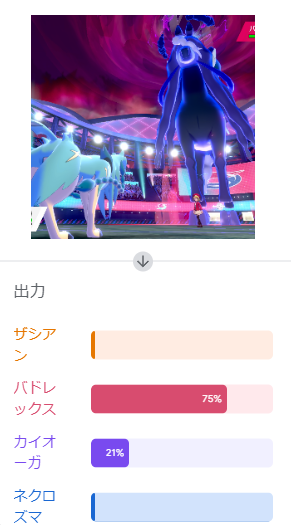

対面からずれた角度

対面からずれた角度から撮影したものを認識させてみました。

うまく認識してくれるでしょうか?

なかなか難しいようです。

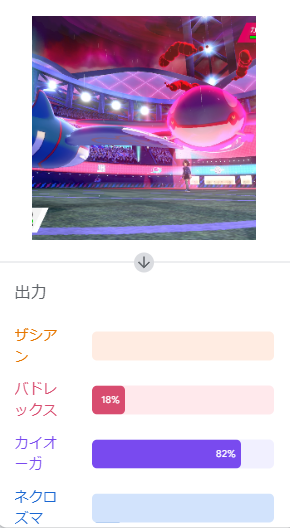

ダイマックス

ちなみにダイマックスしたときの画像はどうでしょうか?

まだいけそうな気がしますがどうでしょう?

天候が雨ならカイオーガ説

ここらへんはちゃんと検証が必要そうですね。

ソルガレオはネクロズマ(日食)と認識してくれるか?

そんなことありませんでした。

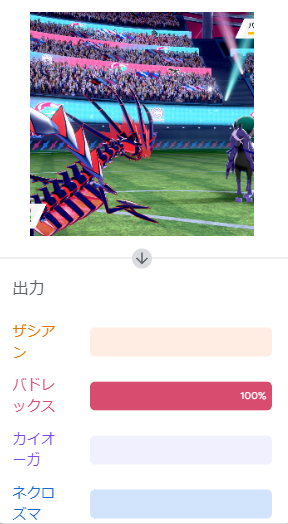

通常ザシアンはザシアンと認識してくれるか?

これはいけるんやね。

まとめ

ポケモンの対面画像を使用して「Teachable Machine」の画像認識で遊んでみました。

ランクマやってる最中にいちいち相手のポケモン入力するの面倒だなと思っていたので、画像認識で解決できないか?のとりあえずの検証でした。

工夫次第では精度があげられると思うので、使えるかもしれないですね。

学習モデルはとりあえず共有しておきます!よかったら遊んでみてね!